Medida pionera y polémica

La ley de la inteligencia artificial, en la recta final: estos son los riesgos que la UE quiere regular

El Parlamento Europeo da luz verde al proyecto para regular la inteligencia artificial

Las universidades a distancia del futuro usarán el reconocimiento facial para combatir la suplantación

Carles Planas Bou

Periodista

Periodista tecnológico entre el mundo digital y la política internacional. Centrado en capitalismo de plataformas, IA, vigilancia y derechos digitales. Excorresponsal en Berlín durante más de cuatro años, cubrió los gobiernos de Merkel, la crisis de los refugiados y el auge de la extrema derecha. También ha trabajado en Europa Central y en Canadá. Graduado en Periodismo por la URL y máster en Relaciones Internacionales por la UAB. Ha colaborado con TV3, TVE, Deutsche Welle, Catalunya Ràdio, El Orden Mundial o El Salto.

Carles Planas Bou

La Unión Europea (UE) ultima la primera ley del mundo que regulará la Inteligencia Artificial (IA). El pasado 14 de junio, la Eurocámara fijó su posición y dio luz verde a una medida pionera que tiene como misión controlar el despliegue de esta emergente tecnología, fijando normas más o menos estrictas dependiendo del nivel de riesgo que entrañe su uso. A pesar de contar con una amplia mayoría, el texto aprobado aún no es el definitivo. Su versión final dependerá de las negociaciones con el Consejo Europeo, integrado por los jefes de Estado o de Gobierno de los 27, una decisión que se espera que llegue antes de finalizar este año.

La ley empezó a gestarse el 21 de abril de 2021. Fue entonces cuando la Comisión propuso regular la IA para prohibir sistemas como la identificación biométrica o la puntuación social, susceptibles de dañar los derechos humanos. Esa preocupación ha centrado gran parte de las negociaciones entre los legisladores. Así, el documento sellado en junio opta por clasificar esta tecnología en función del potencial impacto de su uso. Hay cuatro categorías según el tipo de riesgo: inaceptable, alto y bajo o mínimo.

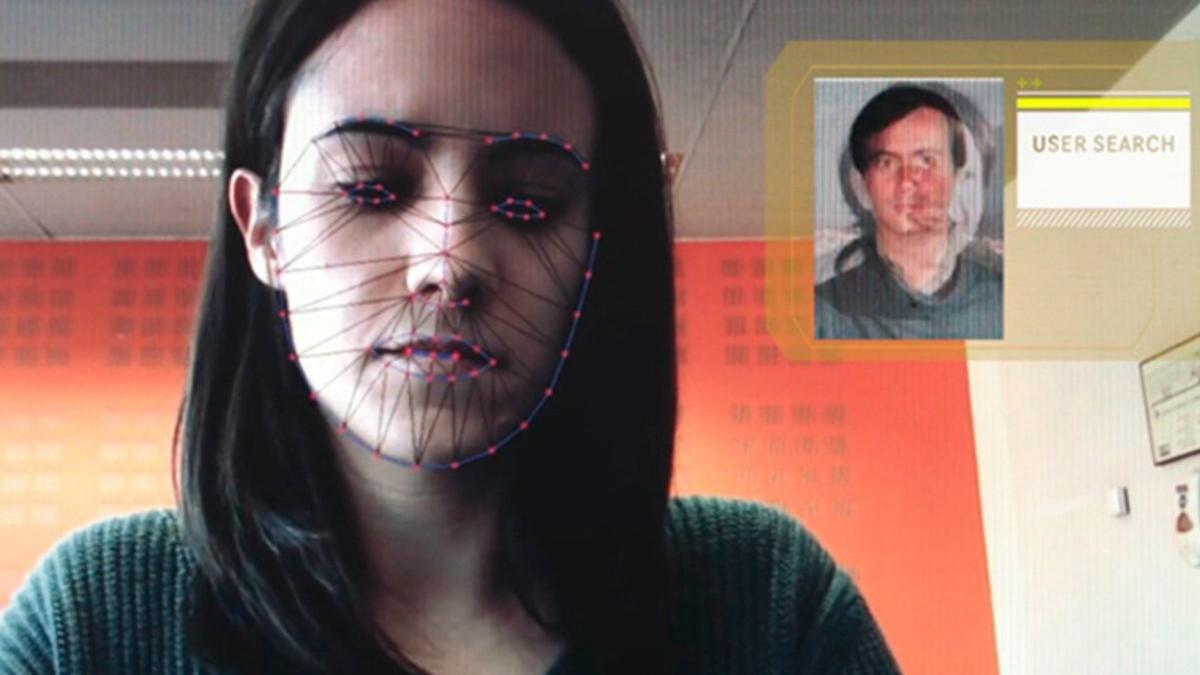

El reglamento vetará todos aquellos sistemas que supongan un "riesgo inaceptable" y una "amenaza para las personas". Según lo propuesto por el Parlamento Europeo, es el caso de la vigilancia policial predictiva o del reconocimiento facial. Este último quedará restringido cuando sea en tiempo real (al contrario de lo que pedía el Partido Popular Europeo), pero se seguirá permitiendo a posteriori en los espacios de acceso público. Más de 155 organizaciones en defensa de los derechos humanos, entre ellas Amnistía Internacional, han exigido una prohibición total de la identificación biométrica.

Usos permitidos

Los otros usos de la IA serán permitidos, si bien deberán someterse distintos grados de control. Los más estrictos serán para los sistemas de "riesgo alto", aquellos que "afecten negativamente a la seguridad o a los derechos fundamentales" de los usuarios. La etiqueta engloba a las herramientas que se apliquen en ámbitos como la educación, el empleo o la gestión de infraestructuras críticas. Para evitar daños, deberán ser evaluadas antes de su comercialización, registradas en una base de datos comunitaria y cumplir criterios de transparencia. La Eurocámara incluye aquí a los algoritmos de recomendación de contenido, lo que intensificaría el escrutinio a las grandes plataformas de internet que los usan, desde Instagram y Google a TikTok y Youtube.

Sin embargo, el texto también despierta no pocas controversias. Una coalición de más de un centenar de oenegés han denunciado que el Artículo 6 introduce un "vacío legal" que permitiría a las empresas de IA decidir si los sistemas que han desarrollado deberían ser reguladas como de "alto riesgo". "Si esto se aprueba la ley será inútil", ha explicado Caterina Rodelli, analista de Access Now, a EL PERIÓDICO. También alertan que los 27 miembros del club comunitario —representados por el Consejo Europeo— presionan en las negociaciones para que el uso de IA en el control de fronteras no deba ceñirse a las mismas reglas de transparencia.

IA generativa

¿Qué pasará con ChatGPT? Según la posición adoptada por el Parlamento Europeo, las herramientas de IA generativa como el chatbot desarrollado por OpenAI figuran dentro de la categoría de "riesgo limitado". Estas únicamente deberán cumplir con obligaciones de transparencia e identificar claramente los contenidos generados artificialmente. "Los usuarios deben ser conscientes de que están interactuando con una máquina para poder tomar una decisión informada sobre si continuar o dar un paso atrás", reza el texto. La intención de esta medida es evitar la proliferación de falsificaciones.

La presión de OpenAI habría ayudado a modificar un borrador inicial de la ley que clasificaba las IA de "propósito general" como ChatGPT dentro de la categoría de "riesgo alto", según documentos obtenidos por la revista Time. Eso habría permitido a esta compañía emergente, participada por Microsoft, esquivar mayores restricciones y exigencias.

La ley también obligará a las empresas que han creado estas herramientas a revelar si han sido entrenadas con material protegido por los derechos de autor. En un principio, miembros del comité legislativo que ha redactado la propuesta pidieron prohibir por completo ese uso sin consentimiento, pero finalmente si impuso el requisito de transparencia.

Debate en juego

Por último, en el peldaño más bajo estará la IA que supone un "riesgo mínimo" o ningún riesgo. Esta categoría incluye la gran mayoría de sistemas desplegados en la UE, desde los filtros automáticos de correo basura (spam, en inglés) a los videojuegos que usan esta tecnología.

"La ley busca frenar las externalidades negativas de la IA, pero regular pronto también puede frenar usos beneficiosos", apunta el analista tecnológico Antonio Ortiz. "La UE está en pleno debate sobre cómo regular rápido y ser a la vez una potencia tecnológica, porque su posición en el desarrollo de sistemas de IA no es muy buena".

Suscríbete para seguir leyendo

- Esta fruta no la come casi nadie, siempre está en los supermercados y está llena de proteína y antioxidantes

- El apellido de origen gitano que tienen más de tres millones de españoles

- Crisis en una escuela compleja de Badalona: pierde a 20 profesores de un plumazo tras el proceso de estabilización docente

- ¿No sabes qué hacer con tanto calabacín? Tres recetas para aprovecharlos

- Un brote de salmonelosis en un bar de Barcelona deja al menos 22 afectados tras comer tortilla de patatas

- Vecinos de Sants piden al Ayuntamiento de Barcelona que compre su bloque para no quedarse sin alquiler

- Estas son las playas de Catalunya con más medusas

- Muere de forma violenta la influencer Catalina Gutiérrez a los 21 años